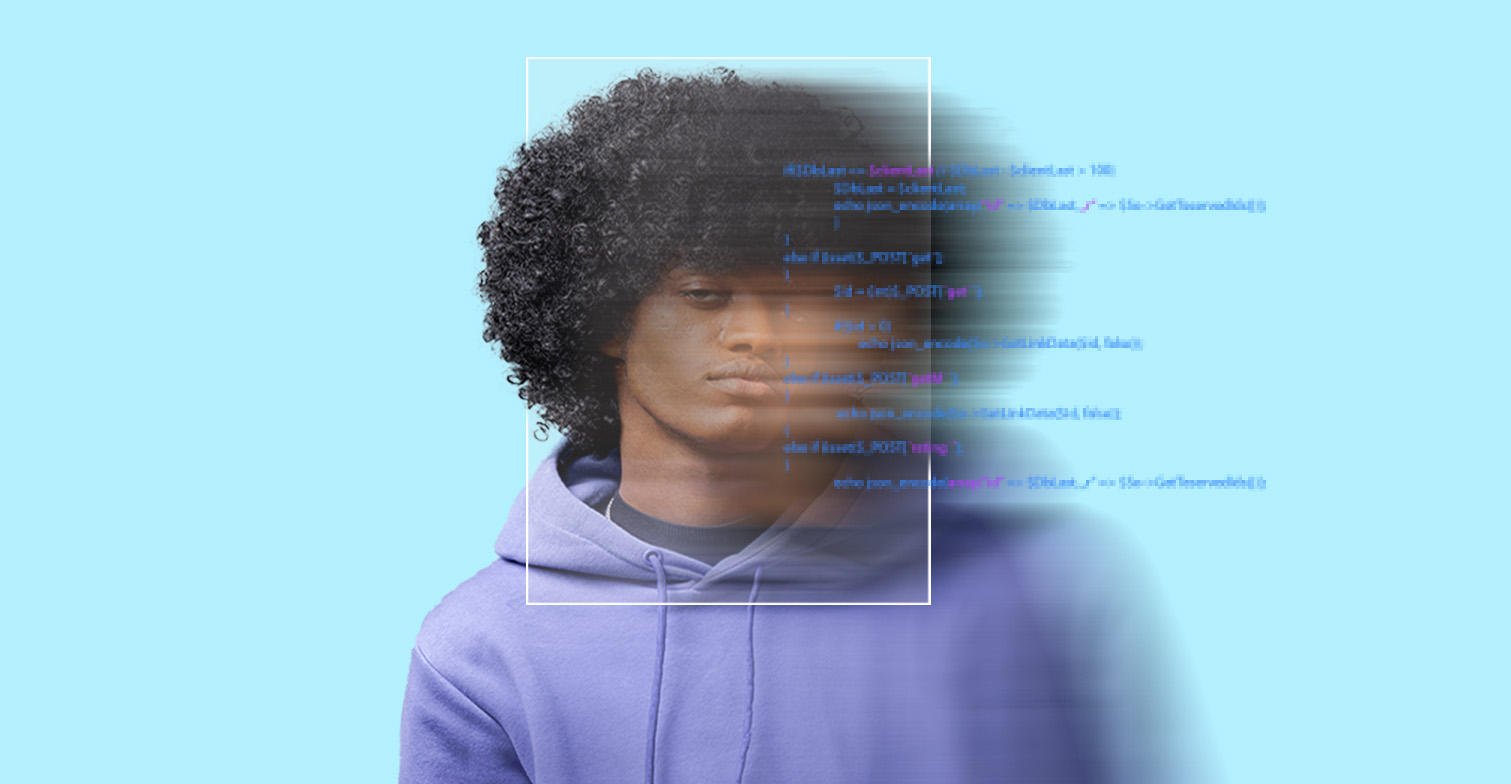

Rassismus im Code: Wie KIs Vorurteile verstärken

Wir alle haben Vorurteile. Deswegen können wir zum Beispiel Bewerber*innen auf einen Job nicht rein objektiv betrachten. Wäre es nicht toll, wenn wir das einer Maschine überlassen könnten, die mittels künstlicher Intelligenz (KI) den*die perfekte*n Kandidat*in auswählt?

KI ist in aller Munde und aus unserem Alltag nicht mehr wegzudenken. Sie lernt aus unseren Daten, erkennt selbstständig Muster und kann dank ihrer komplexen Algorithmen Vorhersagen oder Entscheidungen treffen. Klingt zunächst nicht verwerflich und nach einem Allheilmittel im Alltag.

Doch die Daten, mit denen KIs dazulernen, bilden unsere Gesellschaft ab. Und diese ist nie objektiv. Deshalb sind KIs oft vorurteilsbehaftet und können rassistisch und diskriminierend sein.

Was ist künstliche Intelligenz (KI)?

Künstliche Intelligenz (KI), im Englischen Artifical Intelligence (AI), ist ein Bereich der Informatik, der sich mit der Entwicklung von Computersystemen befasst, die menschenähnliche Intelligenz und Entscheidungsfähigkeiten besitzen. Durch trainierte Algorithmen ermöglicht die KI den Maschinen das Lernen, Problemlösen und eigenständiges Entscheiden.

Künstliche Intelligenz wird in verschiedenen Bereichen wie Sprach- und Bilderkennung, Robotik, Medizin und Verkehrswesen angewandt.

Wie funktionieren KI-Systeme?

KI-Systeme bestehen zunächst aus komplexen Algorithmen, also einer Schritt-für-Schritt-Anleitung, durch die bestimmte Aufgaben gelöst werden sollen. Diese Programme werden von Personen entwickelt.

Wurde der Code geschrieben, greift der Algorithmus auf verschiedene Ansätze und Techniken zurück, um sich selbstständig fortzubilden und Wissen anzuhäufen. Dies kann zum Beispiel durch maschinelles Lernen, neuronale Netzwerke und natürliche Sprachverarbeitung geschehen.

Dabei ist maschinelles Lernen einer der dominierenden Bereiche der künstlichen Intelligenz. Es bezieht sich auf Algorithmen und Modelle, die es Computern ermöglichen, automatisch und ohne Zutun von außen selbstständig aus Daten zu lernen, Muster zu erkennen und Vorhersagen oder Entscheidungen zu treffen.

Wie verstärkt KI Rassismus und Vorurteile?

Kenza Ait Si Abbou Lyadini, ZDF – Programmierte Ungerechtigkeit

In der KI-Branche arbeiten nach wie vor überwiegend weiße Männer. Weltweit betrug der Frauenanteil 2021 im Sektor „Data and AI” gerade mal 32 %. 2020 waren in Deutschland nur 16 % der KI-Mitarbeiter*innen weiblich. So entsteht allein durch die Geschlechterverteilung ein Bias im System, der Frauen benachteiligt.

Kenza Ait Si Abbou Lyadini, ZDF – Programmierte Ungerechtigkeit

Da künstliche Intelligenz mithilfe der Daten unserer Gesellschaft lernt, reflektiert sie auch all unsere Vorurteile und Annahmen. Somit kann sie keine neutralen Aussagen treffen, denn dafür bräuchte es neutrale Daten. Doch diese existieren in unserer Welt nicht. Dadurch entstehen Verzerrungen im Code, deren sich viele nicht bewusst sind.

Beispiele für rassistische KI-Anwendungen

Zusätzlich werden Algorithmen bewusst so programmiert, dass sie beispielsweise polarisierende Inhalte weit häufiger ausspielen, BIPoC (Black Indigenious People of Color) Creator*innen auf sozialen Plattformen in ihrer Reichweite ausbremsen, Frauen falsche medizinische Ratschläge geben, in Bewerbungsprozessen People of Color und Frauen benachteiligen oder Bodyshaming bei Instagram betreiben.

Doch es müssen nicht immer komplizierte KI-Algorithmen sein, die Vorurteile und Rassismus verstärken. Auch technisch etwas einfachere Systeme wie automatische Seifenspender, Automatiktüren oder öffentliche Fotoautomaten diskriminieren Betroffene im Alltag und grenzen aus. Wie? Zum Beispiel durch die Infrarottechnik, die von weißen Menschen programmiert wurde und damit eher hellere anstatt dunkler Haut erkennt.

So entstehen KI-Systeme, die marginalisierte Gruppen noch stärker belasten. Betroffen sind davon vor allem Frauen, BIPoC und die LGBTQIA+ Community.

KI-Rassismus: Herausforderungen und Lösungsansätze

Wenn künstliche Intelligenz Rassismus und Vorurteile verstärkt, fällt das nicht unbedingt allen Menschen und Betroffenen sofort auf. Erkennen Betroffene jedoch, dass sie gerade von einem Algorithmus diskriminiert und ausgegrenzt werden, trauen sich viele nicht, dagegen vorzugehen.

Zwar ist KI schon lange Teil unseres Alltags. Aber die Dimensionen und Risiken hinter den technisch komplizierten Abläufen der stätig dazulernenden Algorithmen sind oft nicht mal den Herstellern bekannt.

Deshalb wird gerade über das Gesetz über künstliche Intelligenz, kurz AI Act, debattiert. Der AI Act soll einheitliche Regeln für den Umgang mit KI in der EU festlegen sowie den Schutz von Bürgerrechten und ethischen Grundsätzen gewährleisten. Die Verordnung definiert verschiedene Risiko-Kategorien von KI-Systemen und legt Anforderungen und Verbote für ihre Verwendung fest.

Neben einem Gesetz, das die KI-Entwicklung reguliert, sollten Daten für maschinelles Lernen zukünftig kritisch hinterfragt und bei Bedarf bereinigt werden. Auch ethische Richtlinien, Diversität in den Entwicklungsteams und transparente Entscheidungsprozesse wären ein Ansatz, um KI neutraler zu gestalten.

Die Rolle der Gesellschaft und unsere individuelle Verantwortung

KI-Technologien lernen von uns und spiegeln damit die Vorurteile, Denkmuster und Ansichten unserer Gesellschaft wider. Es liegt also an uns als Gemeinschaft, unsere Vorurteile gegenüber Randgruppen abzubauen, um gerechtere und vorurteilsfreie KI-Systeme mitzugestalten. Deshalb ist es wichtig, dass wir

- alle gemeinsam darüber debattieren, wie wir in Zukunft mit Algorithmen umgehen wollen,

- lernen zu verstehen, wie KI funktioniert und welche Chancen und Risiken diese mit sich bringt,

- KI-Systeme nicht bewusst mit rassistischem und diskriminierendem Content füttern,

- uns gemeinsam für neutrale Datensätze und eine diverse KI-Entwicklungsgemeinschaft einsetzen.

Schließlich sollen KIs uns das Leben erleichtern, nicht rassistische Diskriminierung und Ausgrenzung fördern.

Titelbild: Shutterstock / kiuikson